LM Studio 是一款本地大语言模型部署与管理的高效工具,专为本地运行、管理和部署大型语言模型而设计,它通过简洁直观的图形界面,让普通用户和开发者能够轻松体验大语言模型的强大功能,同时支持离线运行,确保数据隐私和安全。

LM Studio软件功能

1、离线运行与隐私保护

支持本地离线运行大语言模型,无需依赖网络连接,所有数据完全保留在本地,不上传至云端,充分保护用户隐私。

2、灵活的模型使用方式

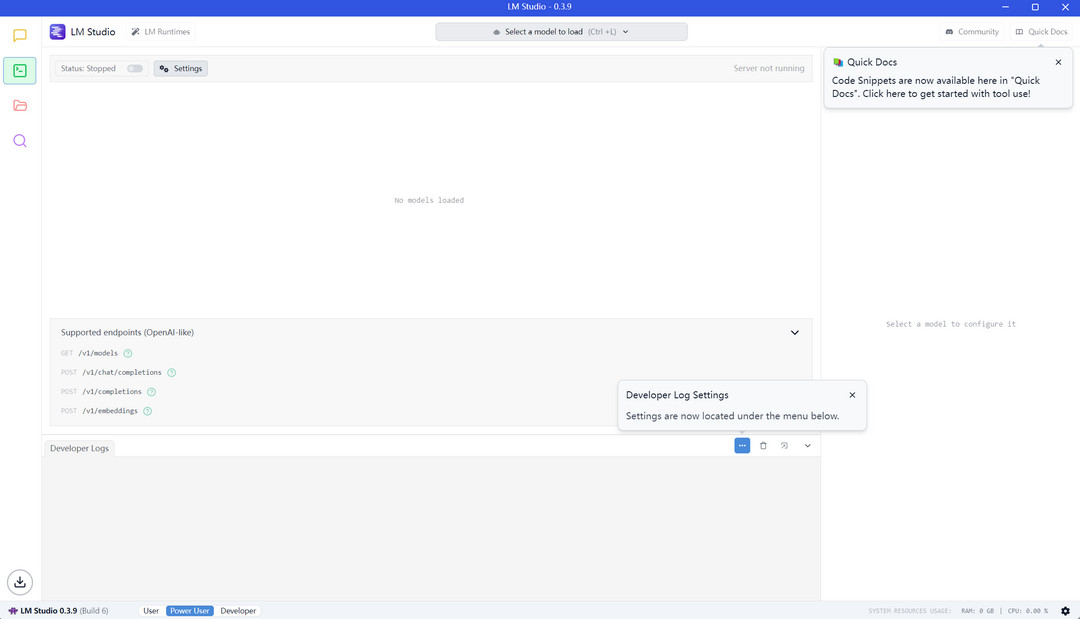

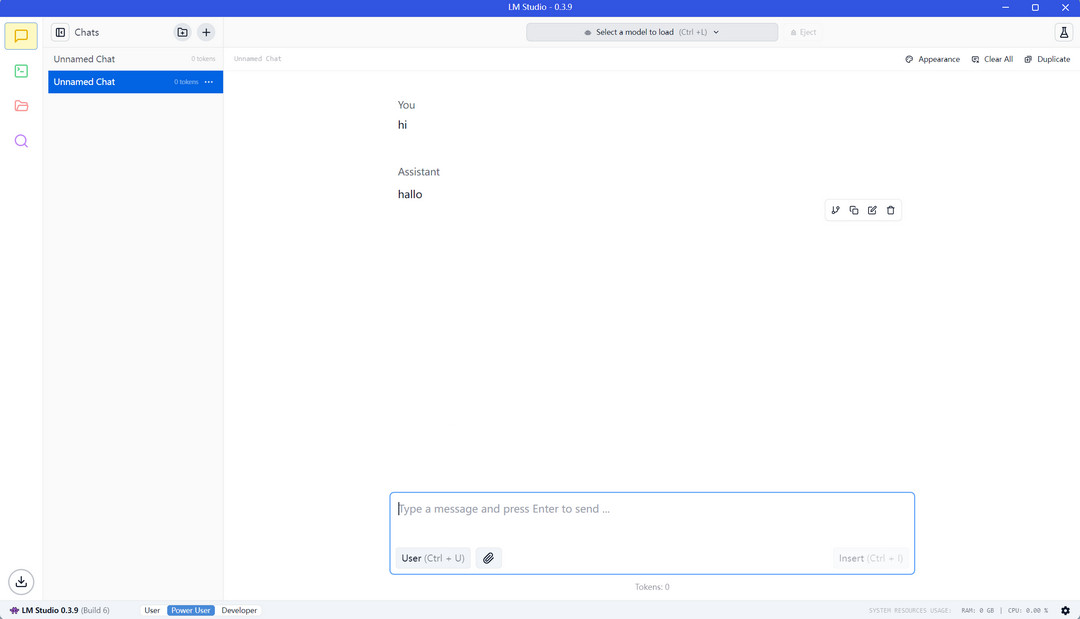

通过内置的聊天界面与模型进行交互,也可通过本地设置的 OpenAI 兼容服务器调用模型 API,方便将模型集成到其他应用程序中。

3、广泛兼容的模型库

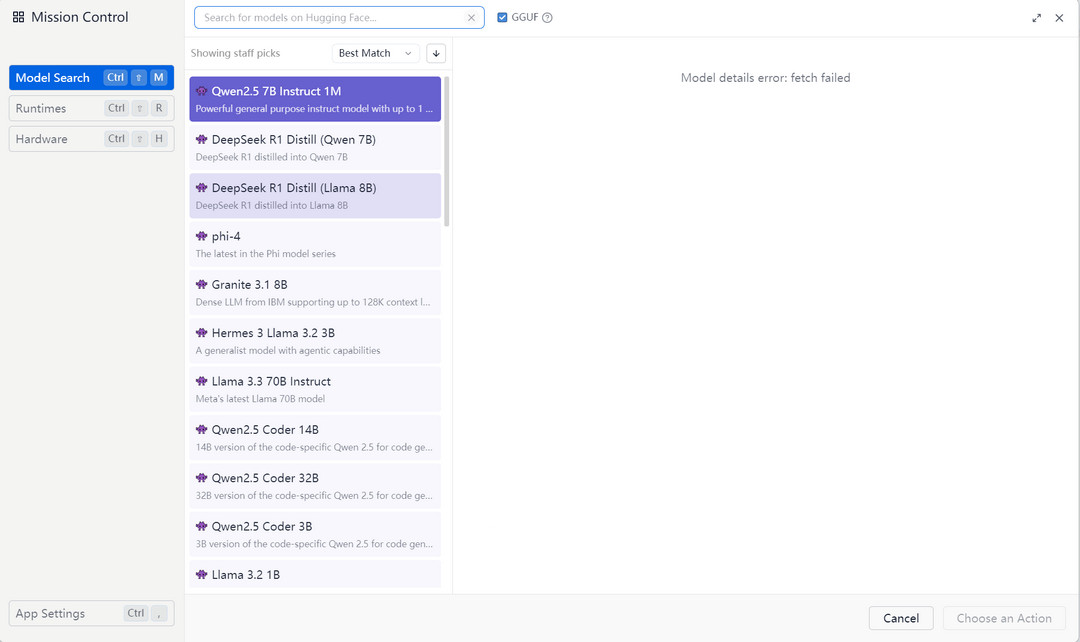

支持从 Hugging Face 模型库下载多种兼容的模型文件,包括基于 ggml 的 Llama、MPT 和 StarCoder 等系列模型。

4、硬件协同优化

依托底层架构优化,LM Studio 支持多种 GPU,并针对显存和内存管理进行了优化,确保在有限的硬件资源下也能平稳运行。

5、社区驱动与资源丰富

LM Studio 的主页会展示最新的模型动态,用户可以在这里与其他用户交流使用心得,共同推动大语言模型技术的发展。

LM Studio软件亮点

1、图形化界面:提供直观的图形界面,无需命令行操作,适合非技术用户快速上手。

2、参数自定义:用户可以灵活调整模型参数,精准定制模型输出。

3、文本检索增强:支持生成文本嵌入向量,结合检索增强生成架构,适用于海量文档和知识库搜索。

4、多平台支持:支持 Windows、macOS 和 Linux 系统,适配多种硬件配置。

安装步骤指南

1、在本站下载LM Studio安装包。

2、下载完成后,双击安装包并按照提示进行安装。

3、安装完成后,打开软件,进入 高级用户模式

4、通过 Mission Control 搜索并下载所需的模型。

5、下载完成后,返回 我的模型,选择并加载模型,即可通过聊天界面或 API 与模型进行交互。

常见问题解答

Q1:LM Studio 支持哪些操作系统?

A:LM Studio 支持 Windows(x86, x64, AVX2)、macOS(M1/M2/M3 系列)和 Linux(Ubuntu 22.04, AVX2)。

Q2:运行 LM Studio 需要什么硬件配置?

A:建议至少配备 16GB RAM 和 6GB VRAM 的 GPU,以确保最佳性能。

Q3:如何加载和使用模型?

A:在 LM Studio 中,通过 Mission Control 搜索并下载模型,下载完成后在 我的模型 中加载即可使用。

Q4:如何解决模型下载速度慢的问题?

A:如果从 Hugging Face 下载模型速度较慢,可以尝试从镜像站下载模型文件,并手动放置到指定路径。

Q5:LM Studio 是否支持 GPU 加速?

A:是的,LM Studio 支持多种 GPU,包括 NVIDIA、AMD 和 Intel 等,用户可以根据硬件配置选择合适的加速方式。

- 软件厂商: LM 工作室

- 软件分类: 办公软件

- 运行环境: WinALL

- 官网地址:https://lmstudio.ai/

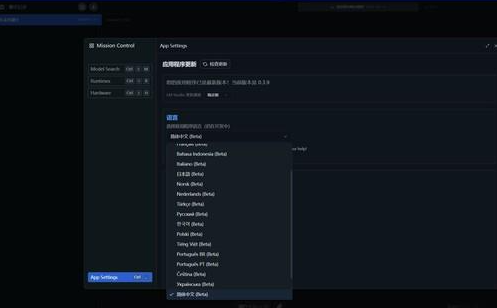

- 软件语言: 简体中文

- 授权: 免费软件

- 软件类型: 系统工具

客户端

客户端 回顶部

回顶部